人工知能の歴史・理論と技術 3

第1次AIブーム末期の様相を軸に、AIが抱えた課題を紹介していきます。

1964~1966 J. WeizenbaumがELIZAを開発

ELIZA(イライザ)は自然言語処理プログラムの試みでした。人間が文字で入力した発言や質問の単語や構文をある程度把握し、それらしい反応を出力します。スクリプトによりさまざまなキャラクターとなることが可能で、もっともよく知られたスクリプトはDOCTORという来談者中心療法セラピストのシミュレーションです。人間の思考や感情についてほとんど知識を与えられていなかったにもかかわらず、DOCTORは時折おどろくほど人間らしい対話をすることがありました。

ELIZAはたいへん大きな反響を呼びましたが、ワイゼンバウム自身の思いとしては、むしろ、人間の言葉を真の意味では理解できないコンピュータの限界を示したいというものだったようです。

1966 機械翻訳に否定的なピアス勧告が出される

機械翻訳は不可能であるとするピアス勧告が出され、この分野への研究資金援助が打ち切られました。

自然言語にはあいまいさや多義性を持つ単語が用いられることなど、機械的な語順の置き換えだけでは済まない困難さがあり、今でも笑わずにいられない訳文しか吐き出せない翻訳ソフトがほとんどです。

翻訳はある文書の中の文脈だけでなく、どのような場面でどのような人に読まれることを前提にしているかによっても左右されるところがあり、そういうことを考慮しなければならないという意味では後述する「フレーム問題」に近いものを内包しています。

1969 J. McCarthyとP. J. Hayesが「フレーム問題」を指摘

チェスやオセロのように、データ化して処理すべき要素が単純なうえに、小さな閉鎖的系に収まっている問題に対しては、人工知能は有効に振る舞うことができます。

しかし、目を現実世界に向けると、事情は大きく変わってきます。AI搭載ロボットに、たとえば「コーヒーメーカーのポットをテーブルまで運んで置く」といった、人間だったら簡単にできる仕事をさせる場合でさえ、その作業に何が関係し、何が関係ないかをAIに学ばせるのはたいへんなのです。

フレーム問題

アメリカの哲学者、ダニエル・デネットが論文の中で示した思考実験が有名ですので、取り上げましょう。

洞窟の中にスペアのバッテリーがありますが、これには時限爆弾が仕掛けられています。時限爆弾が爆発するとバッテリーが破壊され、ロボットはバッテリーの交換ができなくなります。そのため、洞窟の中からバッテリーを運び出す必要があります。そのため、ロボットに「洞窟からバッテリーを運び出すように」と命令することにします。

まず、人工知能ロボット1号機「R1」が投入されました。R1はうまくプログラムされていたため、洞窟に入って無事にバッテリーを運び出すことができました。しかしR1は、バッテリーに爆弾が置かれていることに気づいてはいたのですが、バッテリーを運ぶと爆弾も一緒に運び出してしまうことを考慮せず、理解していなかったのでした。そのため、洞窟から出たところで爆弾が爆発してしまいました。

これは、R1が、バッテリーを取り出すという目的については理解していたものの、その動作にともなって副次的に発生する事項(バッテリーを運び出すと爆弾も同時に運んでしまうこと)について理解していなかったのが原因でした。

そこで、目的を果たす動作を行うにあたって副次的に発生する事項も考慮する人工知能ロボット2号機R1-D1 を開発し、同じミッションに投入しました。しかし、R1-D1は、洞窟に入ってバッテリーの前に来たところで動きを止め、やがて時限装置が作動して爆弾が爆発、ロボットは木っ端みじんに砕け散りました。

R1-D1はバッテリーの前で、「バッテリーを動かすと上にのった爆弾は爆発しないかどうか」「バッテリーを動かす前に爆弾を移動させないといけないか」「爆弾を動かそうとすると、天井が落ちてきたりしないか」「爆弾に近づくと壁の色が変わったりしないか」などなど、副次的に発生しうるあらゆる事項について考え始めてしまい、無限に思考し続けてしまったのです。副次的に発生しうる事項というのが無限に考えられ、そのすべてを考慮するには無限の計算時間を必要とするからです。

ただ、副次的に発生しうる事項といっても、「壁の色がかわったりしないか」などというのは、常識的にとらえれば、ふつうは考慮する必要はありません。

そこで、目的を果たす動作を行うにあたって無関係な事項は考慮しないようにプログラムしなおした人工知能ロボット3号機R2-D1を開発しました。しかしこのロボットは、起動してすぐに、洞窟に入る前に動きを止めてしまいました。R2-D1は動き出してすぐに、ミッションと無関係な事項をすべて洗い出そうとして、「あれも関係ない、これも関係ない」と、無限に思考し続けてしまったのでした。目的と無関係な事項というのもまた無限にあるため、それらすべてを考慮しようとすれば無限の計算時間が必要になってくるからです。

https://gigazine.net/news/20121224-irobot-sugv/

これが人工知能研究における最大の難問、フレーム問題です。バッテリーと爆弾が決まった位置にあり、進路上に障害物がなく、ロボットにあらかじめ動作をプログラムしてやらせるのなら話は簡単なのですが、予定にない事象が起こりうる条件で、それに対応する「知能」を持たせようとすると、「起こりうる事象」は数限りなく考えられ、ミッションに関係するかしないかをチェックするだけでも無限の時間がかかってしまうという問題です。

高度の柔軟性を維持しつつ臨機応変に対処するのはむずかしいのです。

組み合わせ爆発

広がりが有限な閉鎖系の場合にも困難は起こりえます。1973年にライトヒル勧告というものがなされ、AI研究が絶滅の危機に瀕したことがありました。この勧告は「組み合わせ爆発」の問題を指摘するものでした。

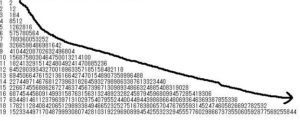

組み合わせ爆発というのは、単純な例では「格子状の道をスタート地点からゴールまで同じところを2度と通らない道順の数」というものが挙げられます。こちらにわかりやすいアニメがあります。

https://blog.goo.ne.jp/lx2x5350/e/f64e69a13c91cff1ed4d7622e2942865

1×1では2通りだったものが、2×2で12通りになり、3×3では184通り……と加速度的に増えていき、6×6で5億7578万0564通りと早くも億のケタに達し、10×10では15687垓5803京0464兆7500億1321万4100通りと、もはやワケがわかりません。

このほか、「巡回セールスマン問題」や「ナップザック問題」など、計算複雑性理論でNP困難、NP完全とクラス付けされる難問があります。

こうした問題に対しては、1970年代のコンピュータはまだまだ非力でした。やっと電卓向けのマイクロチップが出た頃の話です。ライトヒル勧告の指摘による失望はAI研究への資金提供をほとんど停止させ、イギリスでは2大学をのぞくすべてのAI研究が中止されました。

フレーム問題、組み合わせ爆発問題、ハードウェアの力不足といったさまざまな課題が重なり合い、人工知能研究は「冬の時代」に入りました。しばらくの間、大規模データベースの構築と効率的な検索・活用といった分野でのちにAIにも応用される技術の研究などが細々と続けられます。

ちなみに、フレーム問題は原理的に解決不能と思われますが、組み合わせ爆発問題に関しては、一部の問題ではアルゴリズムの見直しにより劇的に短時間で答えが見つかるようになっています。また、ハードウェアの面でも、量子コンピュータが超高速数値演算プロセッサーとして働きうることが期待されており、4種の塩基と操作酵素で演算するDNAコンピュータも、現在のスーパーコンピュータで20年かかる計算を数秒で終わらせる能力を持ちうると考えられ、研究が進められています。

さて次の記事では、第2次AIブームに話を進めます。