人工知能の歴史・理論と技術 5

第2期・冬の時代ではAI研究が停滞したものの、現在の第3次AIブームや将来の「強いAI」に向けた基礎理論・基礎技術が積み重ねられました。その主要なポイントをチェックしておきましょう。

1980~1990年代 Moravecのパラドックス・「身体」の必要が説かれる

1988年、ハンス・モラベックは「論理、数学の問題を解いたり、専門的知識を出力したりといった処理はあまり多くの計算資源を必要とせず、4歳児が簡単にできる感覚運動(歩き回る、人の顔を見分けるなど)を再現する方がより多くの計算資源を必要となる」と指摘。コンピュータにとっては、高度な問題は容易で、(人間にとって)常識的な問題は逆にむずかしいというパラドックスです。

モラベックらは「論理的・数学的問題を解く知能」から出発するトップダウンの発想ではなく、「感覚運動・常識」から出発するボトムアップの方向で人工知能を研究するよう主張しました。ロボット工学者のロドニー・ブルックスも、あえて「知能」を廃し、感覚と運動機能だけを出発点とする人工知能を考えました。

本稿「AI・人工知能について 1」では「利害」の根拠として身体性に言及していますが、感覚運動機能から出発して進化的に知能を目指す方向は「強いAI」に結びついていきそうです。

1990年代 Mooreの法則・コンピュータ性能の劇的向上

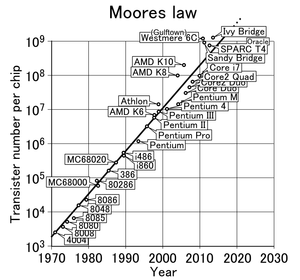

インテル創業者の一人であるゴードン・ムーアは「コンピュータの処理速度とメモリー容量は2年ごとに倍増する」という将来予想を示しました。事実として、コンピュータはそれに近い加速度的進化を遂げてきています。

この急速な進歩は、第1次AIブームを終わらせた要因の1つ、「コンピュータの能力不足」という問題をほぼ解消させました。このことも、のちの第3次AIブームにつながる重要な要素です。

https://ja.wikipedia.org/wiki/%E3%83%A0%E3%83%BC%E3%82%A2%E3%81%AE%E6%B3%95%E5%89%87

1990年代 インターネットの普及・拡大

1990年代初頭から、「パソコン通信」などと呼ばれるネットワーキングが徐々に広がっていきます。1994年にはYahoo!が生まれ、NIFTY-Serveがインターネット接続サービスを開始しました。1995年にはWindows95とInternet Explorer 1.0が発売され、日本でもNTTが「テレホーダイ」のサービスを、SonyがSo-netによるインターネット接続サービスを開始しています。このあたりからインターネットの普及に弾みがつき、以後、急速に拡大していきます。

インターネットの普及拡大は、ネット上の情報量を爆発的に増大させ、のちのAIにとって宝の山となる「情報鉱山」としての性格を帯びていきます。

1990年代 各種エージェントとして裏方で活動・「AI」の名を冠さぬ研究

AI冬の時代でも、AIは「知的エージェント」としてICT技術の中で目立たぬながらも活動を続けていました。ネット購入の履歴からユーザーの嗜好を把握していく「買い物ボット」など自動データ収集、産業ロボットの制御、物流の効率化、医療診断といった領域で、人間の作業をサポート・アシストする役割を裏方として務めています。

他方、この頃のAI研究者は、研究資金が得やすくなるように「失敗した研究」というイメージがこびりついてしまった「AI」とは関係のない名称を研究テーマとして掲げる傾向がありました。インフォマティクス、ナレッジマネジメント、認知システム、計算知能などです。

名前は変わっても、AI理論と技術の積み重ねは、一応続いていたことになります。

2000 制限ボルツマンマシンとコントラスティブ・ダイバージェンス法

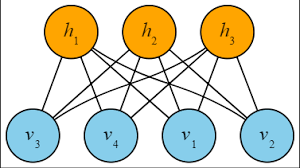

2000年に、制限ボルツマンマシン(Restricted Boltzmann Machine)によるコントラスティブ・ダイバージェンス法(Contrastive Divergence)による効率的な計算が提案されました。

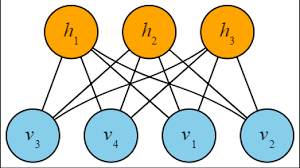

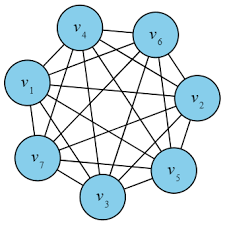

ボルツマンマシンはJ・ヒントンとT・セジュノスキーにより1985年に考案された確率分布(ボルツマン分布)を計算するためのニューラルネットワークです。元々のボルツマンマシンは、入出力層(可視層)と不可視層のユニット(ノード)間がランダムに接続されたもので(無制限ボルツマンマシン)、理論的には、脳内のシナプスのやりとりを並列的に模倣するものでした。しかし、この不規則過程を通して平衡統計を算出するまで、ユニットの数や接続の強度により指数級数的に計算時間が長くなり、現実的な実用性は低いとされます。

http://ai-master.jp/wiki/index.php?%E3%83%9C%E3%83%AB%E3%83%84%E3%83%9E%E3%83%B3%E3%83%9E%E3%82%B7%E3%83%B3

この欠点を改めるため、同一層内の接続はしない制限ボルツマンマシン(RBM)によるコントラスティブ・ダイバージェンス(対比による変更)法が提案されました。不可視層を多層化することで算出される平衡統計の精度と生成モデルの質が向上するとされます。この手法が、のちにディープラーニングが生み出される土壌となりました。重要なところですので、次の記事でもう一度取り上げます。

http://ai-master.jp/wiki/index.php?%E3%83%9C%E3%83%AB%E3%83%84%E3%83%9E%E3%83%B3%E3%83%9E%E3%82%B7%E3%83%B3

2001 M. Minsky「なぜ我々はHAL9000を実現していないのか」

アーサー・C・クラーク原作、1968年にS・キューブリックにより映画化され公開された『2001年宇宙の旅』に登場するAIコンピュータ「HAL9000」。小説では1997年に稼働開始し、2001年にはディスカバリー号とともに木星軌道近くに到達しているという設定でした。

しかし現実にはHAL9000のような高度なAIコンピュータは、2018年になっても実現していません。これがなぜなのか、2001年にミンスキーは問題提起しました。ミンスキー自身は、「常識推論」のようなAIの中心課題を無視し、ニューラルネットワークや遺伝的アルゴリズムの商用利用ばかりを研究してきたからだと考えています。別のある学者はコンピュータの性能不足を原因として挙げ、また別の学者は、ニューラルネットワークを人間の大脳皮質に近づけようとしてこなかったことが原因だとしています。

総じて、「弱いAI」に軸足を置きすぎてきた、という方向の指摘である点では一致しているようです。何事でもそうですが、研究には資金が必要で、どうしても成果の現れやすい、そして評価しやすいAI研究が好まれた結果でしょう。

しかし「強いAI」は人工知能研究の根源であり本来の根幹でもあります。絶えずそこへと立ち帰る努力は今後もされていくでしょう。

そして2006年、ジェフリー・ヒントンにより、ディープラーニングが発明されました。

ここに現在の第3次AIブームが始まります。

次の記事で詳しく見ていくことにしましょう。